Sommaire

Comment comparer les résultats des modèles d’apprentissage non supervisé

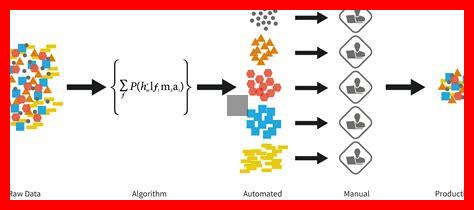

L’apprentissage non supervisé est une branche fascinante de l’intelligence artificielle qui permet d’extraire des motifs et des structures à partir de données sans étiquettes.

. Cependant, évaluer et comparer les résultats de différents modèles d’apprentissage non supervisé peut s’avérer complexe. Cet article explore les méthodes et les critères essentiels pour effectuer cette comparaison de manière efficace.

1. Comprendre les objectifs de l’apprentissage non supervisé

Avant de plonger dans la comparaison des modèles, il est crucial de définir les objectifs de votre analyse. Souhaitez-vous segmenter des données, réduire leur dimensionnalité ou détecter des anomalies ? Chaque objectif peut nécessiter des critères d’évaluation différents. Par exemple, pour la segmentation, la cohésion intra-cluster et la séparation inter-cluster sont des indicateurs clés.

2. Utiliser des métriques d’évaluation appropriées

Il existe plusieurs métriques pour évaluer les résultats des modèles d’apprentissage non supervisé. Parmi les plus courantes, on trouve :

- Silhouette Score : Cette métrique mesure la similarité d’un point avec son propre cluster par rapport aux autres clusters. Un score proche de 1 indique une bonne séparation.

- Davies-Bouldin Index : Plus ce score est bas, meilleure est la séparation entre les clusters. Il évalue la compacité et la séparation des clusters.

- Calinski-Harabasz Index : Ce score compare la variance intra-cluster à la variance inter-cluster. Un score plus élevé indique une meilleure séparation.

3. Visualisation des résultats

La visualisation est un outil puissant pour comparer les résultats des modèles. Des techniques comme le t-SNE ou l’UMAP permettent de projeter des données de haute dimensionnalité en deux ou trois dimensions, facilitant ainsi l’observation des clusters. Des graphiques tels que les dendrogrammes pour les modèles de clustering hiérarchique peuvent également offrir des perspectives précieuses.

4. Validation croisée et robustesse

Pour garantir la fiabilité de vos résultats, il est recommandé d’utiliser la validation croisée. En divisant vos données en plusieurs sous-ensembles et en évaluant les performances des modèles sur ces sous-ensembles, vous pouvez obtenir une évaluation plus robuste. Cela permet également de vérifier la stabilité des clusters obtenus.

Conclusion

Comparer les résultats des modèles d’apprentissage non supervisé nécessite une approche méthodique et l’utilisation de métriques appropriées. En définissant clairement vos objectifs, en utilisant des métriques d’évaluation pertinentes, en visualisant les résultats et en appliquant des techniques de validation croisée, vous serez en mesure de tirer des conclusions significatives sur la performance de vos modèles. L’apprentissage non supervisé, bien que complexe, offre des opportunités passionnantes pour découvrir des insights cachés dans vos données.